用友畅捷通基于Flink构建实时数仓的挑战与数据处理最佳实践

用友畅捷通基于Flink构建实时数仓的挑战与数据处理最佳实践

引言

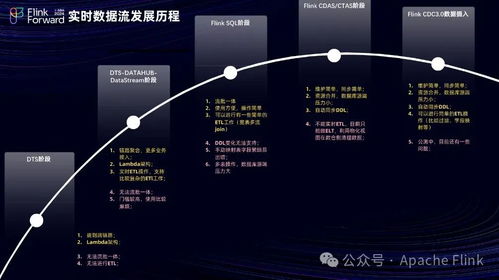

随着企业数字化转型的深入,对数据时效性的要求日益提高,传统T+1模式的离线数仓已难以满足实时业务洞察、风险监控和智能决策的需求。用友畅捷通作为面向小微企业的云服务提供商,其产品线涵盖财务、进销存、CRM等多个领域,业务场景复杂,数据源多样。为支撑其SaaS服务的实时分析与运营,用友畅捷通选择基于Apache Flink这一先进的流处理引擎,构建其新一代实时数据仓库。本文将探讨在此过程中的核心挑战与数据处理领域的最佳实践。

面临的挑战

- 数据源异构性与复杂性:畅捷通服务的数据源包括来自不同SaaS模块的业务数据库(如MySQL、PostgreSQL)、日志文件、消息队列(如Kafka)以及外部API数据。这些数据格式不一(结构化、半结构化),更新频率和语义各异,实现统一的、低延迟的数据接入与融合是首要挑战。

- 流批一体与数据一致性:业务需求往往需要结合实时流数据与历史批量数据进行关联分析。如何设计流批统一的数据模型和处理逻辑,并保证在分布式流处理场景下的精确一次(Exactly-Once)语义和数据最终一致性,是保障分析结果准确性的关键。

- 状态管理与计算性能:实时数仓中涉及大量的有状态计算,如窗口聚合、多维关联、用户行为序列分析等。Flink状态的管理(包括状态大小、访问效率、容错恢复)直接影响到系统的吞吐量、延迟和稳定性。面对海量小微企业数据,优化状态后端和计算逻辑至关重要。

- 维度表变更与实时关联:业务维度数据(如商品信息、客户档案)会发生变化。在实时流中如何及时、准确地关联最新的维度信息(即“流”与“变”的维度表关联),避免使用过时快照导致分析偏差,是一个经典难题。

- 运维与监控复杂性:实时数据流水线是7x24小时运行的,对平台的可观测性、故障自愈能力、资源弹性伸缩以及版本升级等运维工作提出了极高要求。

数据处理最佳实践

针对上述挑战,用友畅捷通在构建基于Flink的实时数仓过程中,出以下数据处理核心实践:

- 分层架构与统一接入层:

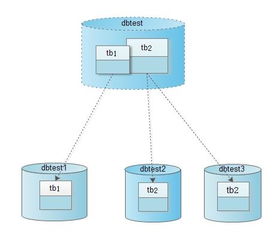

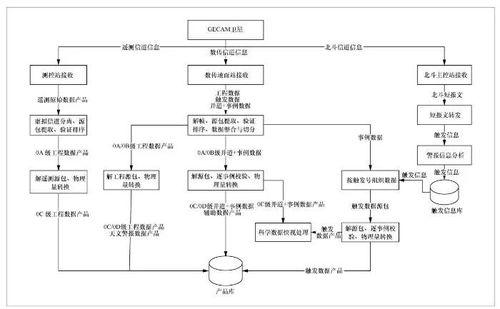

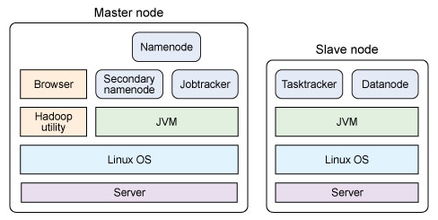

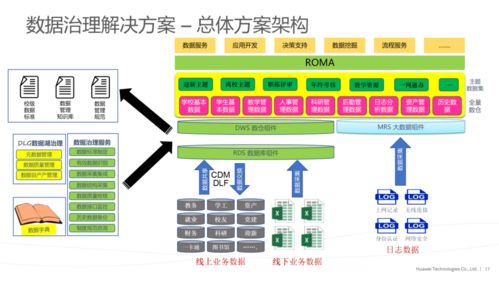

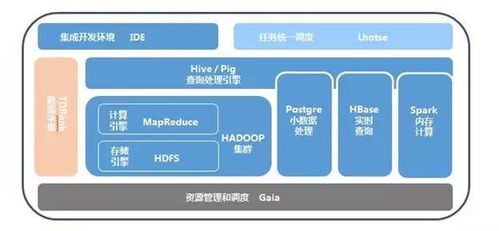

- 架构分层:采用经典的实时数仓分层模型,如ODS(操作数据层)、DWD(明细数据层)、DWS(汇总数据层)和ADS(应用数据层),通过Flink SQL或DataStream API实现各层间的数据流转与加工。

- 统一接入:利用Flink CDC(Change Data Capture)技术,直接捕获源数据库的增量变更日志,将其作为流数据源,实现低延迟、全量+增量的数据无缝入湖/入仓。对于日志和消息队列数据,则通过Flink Connector高效接入。这简化了数据采集流程,保证了数据的时序性和完整性。

- 流批一体SQL与动态表:

- 充分发挥Flink SQL作为流批统一处理语言的优势,使用相同的SQL语法处理无界流数据和有界批数据。将核心业务逻辑通过SQL定义,提升开发效率并降低维护成本。

- 利用Flink的“动态表”概念,将数据流视为一张持续更新的表,通过定义时间属性和水印(Watermark)来处理乱序事件,并结合窗口函数完成复杂的时态计算。

- 状态后端优化与调优:

- 后端选型:对于状态规模大、需要高性能读写的场景,采用RocksDB状态后端,利用其磁盘存储能力承载超大状态,并通过优化RocksDB参数(如内存分配、压缩策略)来提升性能。

- 状态TTL与清理:为键控状态(Keyed State)设置合理的生存时间(TTL),自动清理过期无用状态,防止状态无限膨胀。

- 检查点与保存点优化:合理配置检查点(Checkpoint)间隔和超时时间,采用增量检查点减少每次快照的开销。利用保存点(Savepoint)实现作业版本的安全升级和状态迁移。

- 维度表实时关联方案:

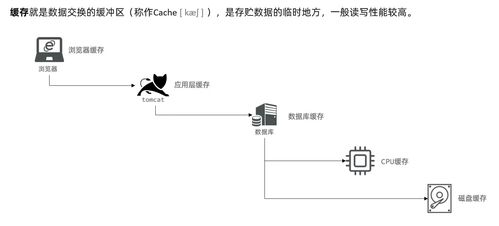

- 主流方案:对于变化缓慢的维度表,采用定期(如每分钟)全量加载到内存(如使用Flink的

CachingTableSource)或分布式缓存(如Redis)中,流数据通过异步查询进行关联。

- 高级方案:对于变化频繁的维度,将维度表自身也通过CDC技术转换为变更流,使用Flink的“时态表函数”(Temporal Table Function)或“时态表连接”(Temporal Table Join)进行流式关联,确保每条事实记录都能关联到其发生时刻准确的维度版本,实现真正的“实时”拉链效果。

- 端到端数据一致性保障:

- 结合Flink的检查点机制与下游支持两阶段提交(2PC)的存储系统(如Apache Kafka事务、支持事务的数据库),实现端到端的精确一次处理语义。例如,使用Flink-Kafka Connector的“精确一次”模式,确保数据从摄入到输出不丢不重。

- 完善的监控与运维体系:

- 指标监控:全面收集Flink作业的指标(吞吐量、延迟、背压、Checkpoint时长与大小、状态大小等),并与Prometheus、Grafana等监控系统集成,实现可视化监控与报警。

- 日志与追踪:集中管理作业日志,并集成分布式追踪系统(如SkyWalking, Jaeger),追踪数据在流水线中的处理路径,便于快速定位瓶颈和故障。

- 平台化运维:基于Kubernetes实现Flink作业的自动化部署、弹性扩缩容和高可用管理,提升整体运维效率。

与展望

用友畅捷通通过采用Apache Flink构建实时数仓,有效应对了海量、多源、实时数据处理的需求,为上层实时大屏、业务预警、智能推荐等应用提供了坚实的数据基础。实践表明,成功的关键在于:选择流批一体的技术架构以简化模型;利用CDC等技术实现低延迟数据集成;通过状态管理和关联优化保障处理性能与准确性;并构建自动化的运维体系确保系统稳定。随着Flink流批一体生态的进一步成熟以及湖仓一体架构的演进,实时数仓将向着更实时、更智能、更统一的方向持续发展,为业务创造更大价值。

如若转载,请注明出处:http://www.tobeonetop.com/product/72.html

更新时间:2026-02-25 07:36:25